Herald-Lab

상관분석, 회귀분석, 선형회귀 본문

통계학(statistics): 데이터를 기반으로 불확실성(uncertainty) 속에서도 합리적인 의사결정을 돕는 수학의 한 분야

- 경험과학에서 발생할 수 있는 불확실성을 계량적으로 설명하기 위한 논리와 방법을 제공한다.

- statistics는 자료를 수집, 분류, 분석, 표현하여 어떤 현상에서의 인과관계를 논리적으로 설명하고, 나아가 미래 상황까지 예측하게 해준다.

통계학은 크게,

① 기술통계학(descriptive statistics; 관찰한 자료를 수집·정리·요약하여 현재의 상황을 이해하고자 함)과

② 추리통계학(inferential statistics; 모집단에서 추출된 표본 자료를 분석하여 확률이론을 근거로 모집단의 특성을 추리하는 데 중점)로 나뉜다.

③ 분석통계학: 합리적 의사결정을 위해 통계적 방법론에 입각하여 분석함 ⇒ 상관분석, 회귀분석, 분산분석 등

로 구분할 수 있다.

상관분석과 회귀분석

Correlation Analysis and Regression Analysis

상관분석: 두 변량 사이의 선형 관계의 유무, 크기, 방향성 등 두 변량(또는 함수적으로 표현하면 변수) 간의 밀접도(상관관계)를 수치적으로 파악하기 위한 통계적 분석법

- 상관성(correlation): 두 변량 간의 상관 관계성 cf. 두 변량의 인과관계성이 아니다.

- correlation analysis의 핵심은 상관계수를 구하는 것이다.

찰스 다윈의 사촌으로 유명한 잉글랜드의 생물학자 프랜시스 골턴(Sir Francis Galton, 1822-1911)은 통계학에서의 상관계수 개념을 최초로 제시했고, 이후 잉글랜드의 칼 피어슨(Karl Pearson, 1857-1936)은 현대 통계수리학을 정립하면서 상관분석을 이론적으로 완성했다.

상관계수는 독립변수와 종속변수의 관계 정도를 1과 -1 사이로 정량화한 것으로 독립변수와 종속변수가 함께 변화하는 정도를 두 변수가 따로 변하는 정도로 나눈 값이다.

- 독립변수에 의해 종속변수의 값이 항상 일정하게 변화하여 완전한 직선형 그래프를 그릴 때, 그 상관은 단일 인과성을 갖는다.

- 두 변수 간의 관계는 x-y 2차원 평면 그래프에서 산포도(variability, variation, dispersion) 또는 산점도로 형식으로 나타난다.

- 양의 산포도: x축의 독립변수가 증가할 때, y축의 종속변수가 비교적 일정하게 증가하는 산포도, 두 변량은 양의 상관관계를 갖는다고 할 수 있다.

- 음의 산포도: x축의 독립변수가 증가할 때, y축의 종속변수가 비교적 일정하게 감소하는 산포도, 두 변량은 음의 상관관계를 갖는다고 할 수 있다.

- 상관계수는 기호 r로 표현되며, -1에서 1사이의 값으로 나타나 상관성을 나타낸다.

- 음의 단일 인과관계: r=-1

- 음의 상관관계: -1<r<0

- 무상관관계: r=0, 두 변량 간의 correlation이 발견되지 않는다.

- 양의 상관관계: 0<r<+1

- 양의 단일 인과관계: r=+1

회귀분석: 변수 사이의 확률적 함수 관계를 탐색하는 수학적 방법론

- regression은 Galton의 저서 <Family Likeness in Stature>(1886)에서 처음으로 사용됨

※ Galton은 자신의 사촌 형 Darwin의 저서인 <종의 기원>을 읽고 유전의 영향력에 심취하였다. 그리고 그는 개체(individuals)가 처한 환경보다 유전자가 개체 특성에 더 많은 영향을 준다고 확신하게 되었다. Galton은 이런 유전적 우월성 및 경향을 조사하기 위해, 주변인들의 키를 전수 조사했다. 그는 이후 놀라운 사실을 하나 발견했는데, 키가 큰 아버지는 그보다 키가 조금 작은 자식을 평균적으로 낳는 반면, 키가 작은 아버지는 다시 그보다 키가 좀 더 큰 자식을 낳는 것이었다. Galton은 이를 유전에서의 평균으로의 회귀(regression toward mean)이라고 명명했다.

- Galton의 결론: 유전 가능한 특성(traits)은 장기적으로 평균으로 회귀하려 한다.

독립변수와 종속변수

- 독립변수(독립변량, independent variable, IV): 다른 변수에 영향을 주는 변수, 변량

- 종속변수(종속변량, dependent variable, DV): 다른 변수로부터 영향을 받는 변수로 통계를 통한 미래 예측을 하는 경우엔 현상의 예측 결과값과 같다.

- 매개변수(parameter, intervening variable): IV와 DV 간의 직접적인 관계가 없을 때, 둘 사이의 간접적 연결(매개)만을 맡는 변수

선형회귀

Linear Regression

2변량 단순회귀분석: 선형적인 1차식으로 변량 간의 관계성을 설명하는 것

- 기하학적으로 독립변수와 종속변수의 관계가 2차원에서는 직선형태로, 3차원에서는 평면형태로 나타난다.

- 독립변수는 1차항임

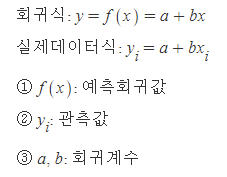

- linear regression의 함수만족꼴

① f(x+y)=f(x)+f(y)

② f(Ax)=Af(x) (단, A는 상수이다.)

만약 독립변수에 x^n, cosx 등의 항이 존재하면 비선형화 된다.

Linear Regression의 개념

- regression: dispertion이 선형관계의 평균값으로 돌아감을 의미

- linearity: 두 변수 간의 관계가 하나의 직선 형태로 설명될 수 있는 관계성

- linearity의 중심: 최소제곱법(least squares)을 만족하는 지점, 예측치와 관측치 차이의 제곱의 합이 최소가 되는 직선

Simple Linear Regression Model

정의: simple linear regression의 변량간 의존관계가 1차 함수로 나타나는 model

독립변수와 종속변수는 각각 1개이고, 차수는 1차이다.

simple linear regression은 두 개의 변수 x, y의 관계를 잘 나타낼 수 있는 linear model을 찾는 것이고, 이 모델을 찾기위해서는 위의 수식에서 a와 b를 구해야 한다.

Least Squares

최소제곱법은 실제 y의 값과 모델에서 얻은 추정값 a+b(x)_i 사이의 차이인 오차항 e를 이용한다.

모든 데이터 세트에 대한 e를 구하고 다시 그 오차를 제곱하여 모두 더한 값이 최소가 되는 a와 b를 구하면 회귀식을 얻게 된다.

- 변수 x와 y 간의 관계를 가장 잘 나타냄은 즉 (x, y)의 좌표로 나타낸 점들에 가장 가까운 직선을 찾는 것이다. ⇒ 모든 점들과의 거리의 합이 최소가 되는 직선을 찾는 것이 목표임

각 점들과의 직선 거리를 e_i라고 하고, 이 직선거리들의 제곱의 전체합 SSE(sum of squared errors of prediction, error sum of squares)를 최소화하는 방법이 최소제곱법이다.

- n은 학습 데이터의 크기를 나타낸다.

- 특히, 위와 같이 계산된 b의 크기와 부호로 독립변수가 종속변수에 주는 상관성을 추정할 수 있다.

또한 오차의 제곱을 모두 더한 SSE를 다음과 같이 연산하여 a와 b를 구할 수도 있다.

SSE에 계산의 편의를 위한 상수 1/2을 곱하면, 새로운 목적함수 E를 설정할 수 있는데, 이를 활용하여 a와 b에 새로운 의미를 부여할 수 있다.

'심리학' 카테고리의 다른 글

| 【수리심리학】 03. 노력의 배신? 연습의 멱법칙(Power Law) <PART 1> (0) | 2026.01.25 |

|---|---|

| 【수리심리학】 02. 인간의 주관적 지각: 페히너의 법칙 (0) | 2026.01.21 |

| 【수리심리학】 01. 베버의 법칙 (0) | 2026.01.19 |

| 【Artificial Intelligence / 인공지능학】 인공신경망의 기초 (0) | 2021.11.06 |

| 인공지능에 관하여 (0) | 2021.11.06 |